使用专用任务模型提升性能

Open-WebUI提供多项自动化功能——如标题生成、标签创建、自动完成和搜索查询生成——以增强用户体验。然而,这些功能可能会对您的本地模型产生多个同时请求,这可能会影响资源有限系统的性能。

本指南解释了如何通过配置专用的轻量级任务模型或选择性禁用自动化功能来优化您的设置,确保您的主要聊天功能保持响应性和高效性。

[!TIP]

为什么Open-WebUI感觉很慢?

默认情况下,Open-WebUI有几个后台任务,这些任务可以让它感觉像魔法一样,但也会对本地资源造成很大负载:

- 标题生成

- 标签生成

- 自动完成生成(此功能在每次击键时触发)

- 搜索查询生成

这些功能中的每一个都会向您的模型发出异步请求。例如,来自自动完成功能的连续调用可能会显著延迟在内存或处理能力有限的设备上的响应,例如运行32B量化模型的32GB RAM Mac。

优化任务模型可以帮助将这些后台任务与您的主聊天应用程序隔离,提高整体响应性。

⚡ 如何优化任务模型性能

按照以下步骤配置高效的任务模型:

步骤1:访问管理面板

- 在浏览器中打开Open-WebUI。

- 导航到管理面板。

- 点击侧边栏中的设置。

步骤2:配置任务模型

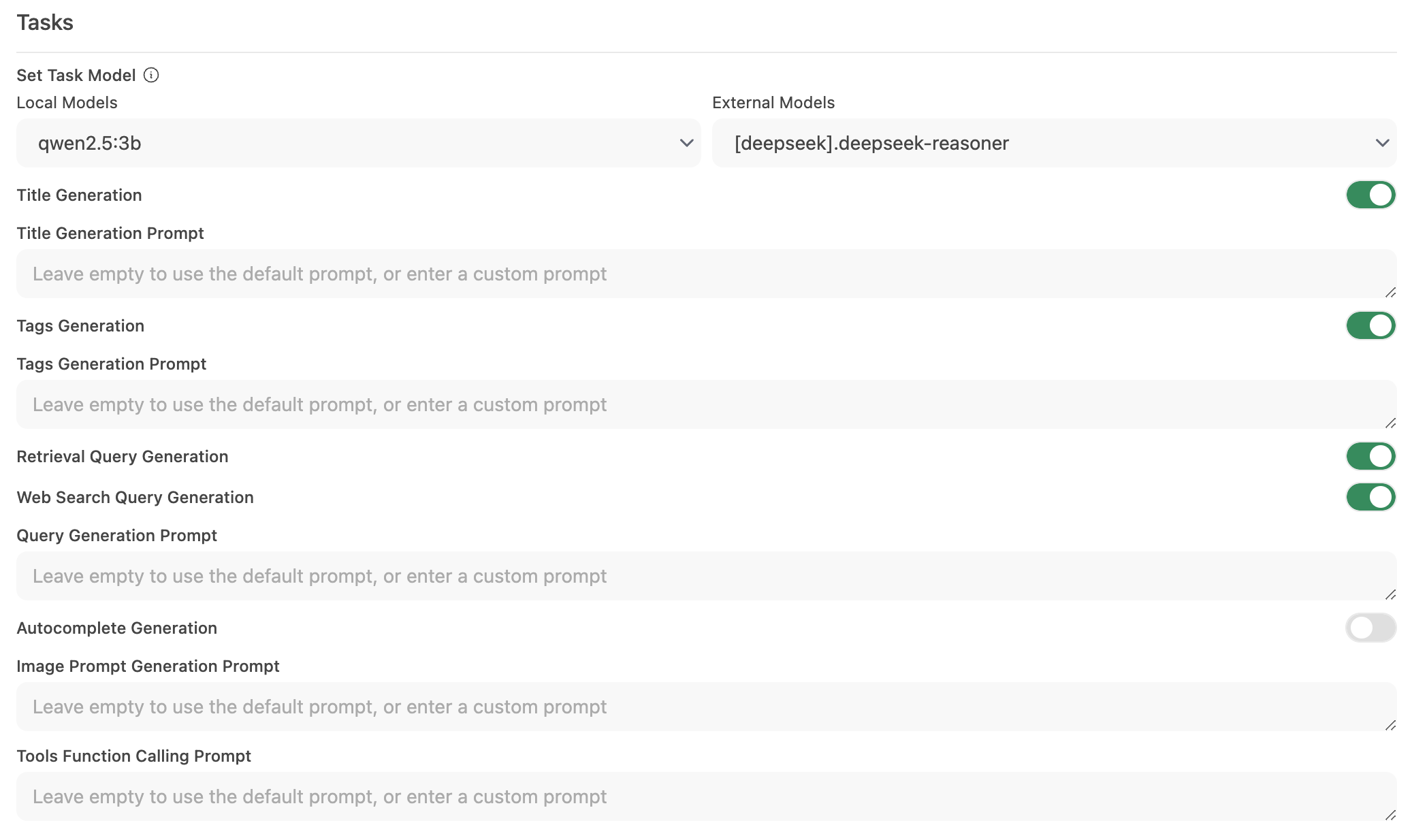

-

转到界面 > 设置任务模型。

-

根据您的需求选择以下选项之一:

-

轻量级本地模型(推荐)

- 选择紧凑的模型,如Llama 3.2 3B或Qwen2.5 3B。

- 这些模型提供快速响应,同时消耗最少的系统资源。

-

托管API端点(最大速度)

- 连接到托管API服务来处理任务处理。

- 这可能很便宜。例如,OpenRouter以每百万输入令牌少于1.5美分的价格提供Llama和Qwen模型。

-

禁用不必要的自动化

- 如果不需要某些自动化功能,请禁用它们以减少多余的后台调用——特别是自动完成等功能。

-

步骤3:保存更改并测试

- 保存新配置。

- 与您的聊天界面交互并观察响应性。

- 如有必要,通过进一步禁用未使用的自动化功能或尝试不同的任务模型进行调整。

🚀 本地模型推荐设置

| 优化策略 | 好处 | 推荐用于 |

|---|---|---|

| 轻量级本地模型 | 最小化资源使用 | 硬件有限的系统 |

| 托管API端点 | 提供最快的响应时间 | 具有可靠互联网/API访问的用户 |

| 禁用自动化功能 | 通过减少负载最大化性能 | 专注于核心聊天功能的用户 |

实施这些建议可以大大改善Open-WebUI的响应性,同时允许您的本地模型有效地处理聊天交互。

💡 其他提示

- 监控系统资源: 使用操作系统的工具(如macOS上的活动监视器或Windows上的任务管理器)监控资源使用情况。

- 减少并行模型调用: 限制后台自动化可防止同时请求压垮您的LLM。

- 尝试不同配置: 测试不同的轻量级模型或托管端点,以找到速度和功能之间的最佳平衡。

- 保持更新: Open-WebUI的定期更新通常包括性能改进和错误修复,因此请保持软件最新。

通过应用这些配置更改,您将支持更响应和高效的Open-WebUI体验,允许您的本地LLM专注于提供高质量的聊天交互,而不会有不必要的延迟。