warning

本教程是社区贡献,不受 Open WebUI 团队支持。它仅作为如何为您的特定用例自定义 Open WebUI 的演示。想要贡献?查看贡献教程。

Helicone 与 Open WebUI 集成

Helicone 是一个开源的 LLM 可观测性平台,供开发者监控、调试和改进生产就绪的应用程序,包括您的 Open WebUI 部署。

通过启用 Helicone,您��可以记录 LLM 请求、评估和实验提示,并获得即时洞察,帮助您自信地将更改推送到生产环境。

- 跨模型类型的实时监控和统一视图:通过单一界面监控本地 Ollama 模型和云端 API

- 请求可视化和重放:准确查看发送到 Open WebUI 中每个模型的提示以及 LLM 生成的输出以进行评估

- 本地 LLM 性能跟踪:测量自托管模型的响应时间和吞吐量

- 按模型的使用分析:比较 Open WebUI 设置中不同模型之间的使用模式

- 用户分析以了解交互模式

- 调试功能以排除模型响应问题

- 跨提供商的 LLM 使用成本跟踪

如何将 Helicone 与 OpenWebUI 集成

步骤 1:创建 Helicone 账户并生成您的 API 密钥

创建一个 Helicone 账户 并登录以在此处生成 API 密钥。

— 确保生成仅写入 API 密钥。这确保您只允许向 Helicone 记录数据,而无法读取您的私有数据。

步骤 2:创建 OpenAI 账户并生成您的 API 密钥

创建一个 OpenAI 账户并登录 OpenAI 开发者门户 以生成 API 密钥。

步骤 3:使用 Helicone 的基础 URL 运行您的 Open WebUI 应用程序

要启动您的第一个 Open WebUI 应用程序,请使用来自 Open WebUI 文档 的命令并包含 Helicone 的 API 基础 URL,这样您就可以自动查询和监控。

# 设置您的环境变量

export HELICONE_API_KEY=<YOUR_API_KEY>

export OPENAI_API_KEY=<YOUR_OPENAI_API_KEY>

# 运行集成了 Helicone 的 Open WebUI

docker run -d -p 3000:8080 \

-e OPENAI_API_BASE_URL="https://oai.helicone.ai/v1/$HELICONE_API_KEY" \

-e OPENAI_API_KEY="$OPENAI_API_KEY" \

--name open-webui \

ghcr.io/open-webui/open-webui

如果您已经部署了 Open WebUI 应用程序,请��转到 管理面板 > 设置 > 连接 并点击"管理 OpenAI API 连接"的 + 号。更新以下属性:

- 您的

API Base URL应该是https://oai.helicone.ai/v1/<YOUR_HELICONE_API_KEY> API KEY应该是您的 OpenAI API 密钥。

![]()

步骤 4:确保监控正常工作

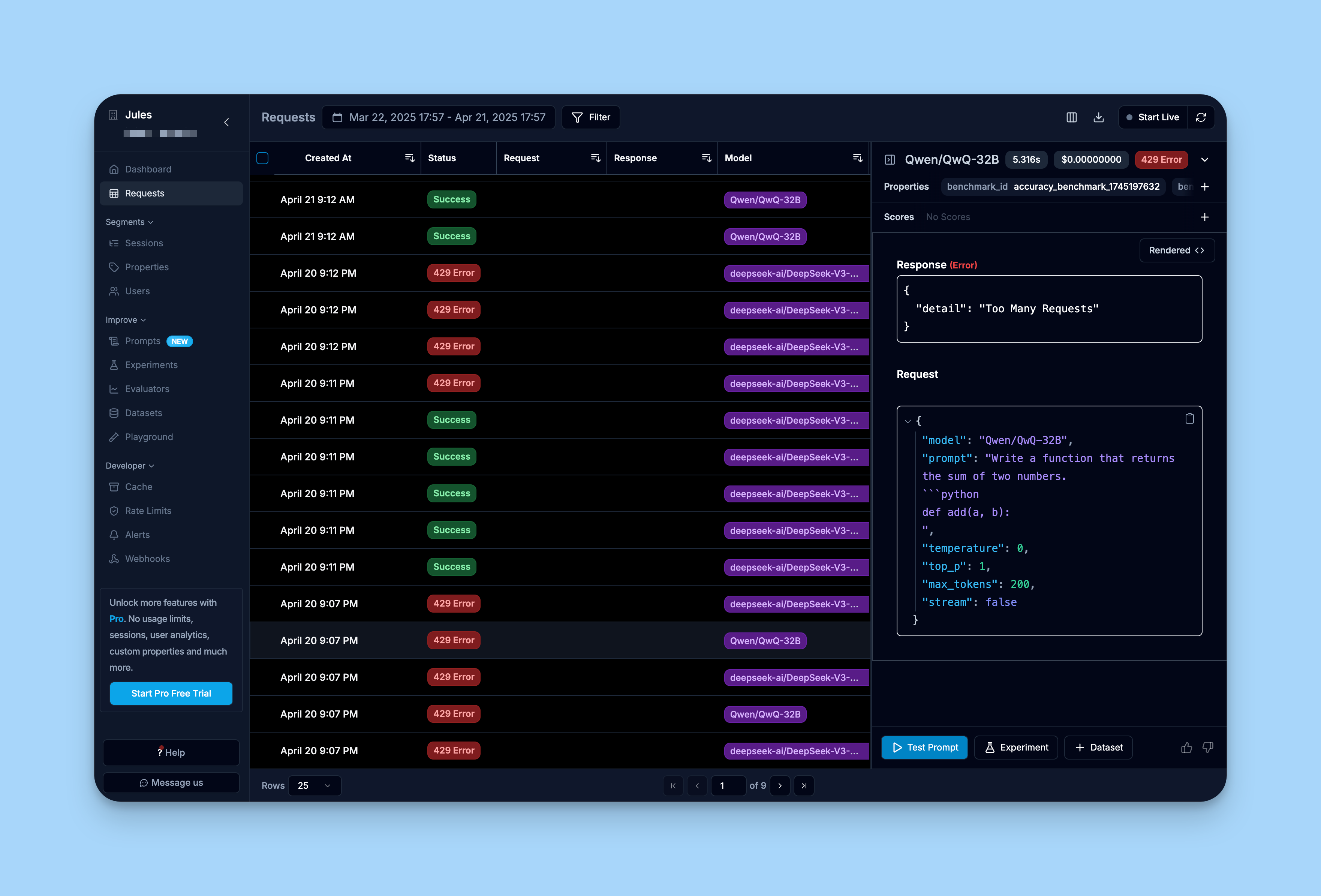

要确保您的集成正常工作,请登录 Helicone 的仪表板并查看"Requests"选项卡。

您应该看到通过 Open WebUI 界面发出的请求已经被记录到 Helicone 中。

了解更多

有关 Helicone 的综合指南,您可以查看这里的 Helicone 文档。